在當今嵌入式系統與物聯網(IoT)飛速發展的時代,將機器視覺和人工智能(AI)能力引入到資源受限的微控制器上,已成為一個極具挑戰性和前景的方向。MicroPython,作為一種精簡高效的Python 3實現,為嵌入式開發帶來了前所未有的便捷性。本篇文章將引導您動手實踐,在MicroPython環境下探索機器視覺的圖像基礎,并邁出人工智能基礎軟件開發的第一步。

一、環境搭建與硬件準備

要進行機器視覺開發,首先需要選擇合適的硬件。常見的搭配包括:

- 主控板:如ESP32、ESP32-CAM(集成了攝像頭)、OpenMV Cam(專為機器視覺設計的MicroPython板)或樹莓派Pico。ESP32-CAM因其價格低廉且集成OV2640攝像頭,是極佳的入門選擇。

- 攝像頭模塊:如果主控板未集成,可選擇OV7670、OV2640等支持MicroPython驅動的模塊。

- 開發環境:

- Thonny IDE:對MicroPython支持友好,可方便地上傳代碼和文件。

- uPyCraft 或 VS Code with MicroPython插件。

確保硬件正確連接,并將最新的MicroPython固件刷入主控板。對于ESP32-CAM,通常需要額外連接串口轉換器進行編程。

二、機器視覺基礎:圖像的獲取與表示

在計算機中,圖像本質上是數據的矩陣。灰度圖像是一個二維矩陣,每個像素點由一個數值(如0-255)表示其亮度。彩色圖像(如RGB)則是一個三維矩陣,通常由紅、綠、藍三個通道的二維矩陣疊加而成。

在MicroPython中,我們可以使用sensor模塊(在OpenMV或適配的庫中)來捕獲圖像。

示例:捕獲并顯示圖像基本信息

`python

import sensor

import time

初始化攝像頭

sensor.reset()

sensor.setpixformat(sensor.RGB565) # 設置像素格式,RGB565比RGB888節省內存

sensor.setframesize(sensor.QVGA) # 設置圖像大小:320x240

sensor.skip_frames(time = 2000) # 等待攝像頭設置生效

clock = time.clock()

while(True):

clock.tick()

img = sensor.snapshot() # 捕獲一張圖像

# 圖像數據img現在是一個對象,它包含了像素矩陣

# 打印圖像尺寸和幀率

print("圖像尺寸:", img.width(), "x", img.height())

print("幀率:", clock.fps())

# 訪問特定像素點 (x=100, y=50) 的RGB值

pixelvalue = img.getpixel(100, 50)

print("像素(100,50)的值:", pixel_value) # 對于RGB565,這是一個16位整數`

三、基礎圖像處理操作

在獲取圖像后,可以進行一系列基礎處理,為后續的AI分析做準備。

1. 灰度轉換:將彩色圖像轉換為灰度圖,減少數據量。

`python

img = sensor.snapshot()

grayimg = img.tograyscale()

`

2. 圖像二值化:通過設定閾值,將灰度圖轉換為只有黑(0)白(255)的圖像,用于輪廓提取。

`python

binaryimg = grayimg.binary([(0, 64)]) # 將亮度0-64的像素變為白色

`

3. 邊緣檢測:使用簡單的算法(如Canny)找出圖像中的邊緣。MicroPython中可能需要自己實現或使用輕量級庫。

4. 尋找色塊或輪廓:這是機器視覺中常用的功能,用于識別特定顏色的物體或物體的形狀。

`python

# 尋找圖像中的所有紅色色塊

redblobs = img.findblobs([(30, 60, 10, 50, 10, 50)], pixelsthreshold=100, areathreshold=100)

for blob in red_blobs:

# 繪制矩形框

img.draw_rectangle(blob.rect())

# 打印中心坐標

print("色塊中心:", blob.cx(), blob.cy())

`

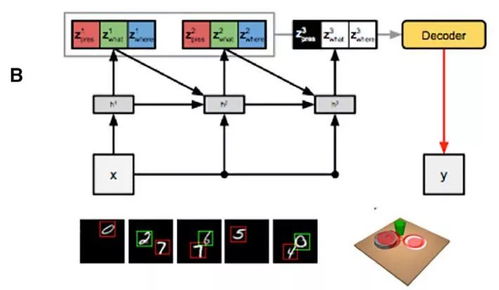

四、邁向人工智能:特征提取與簡單分類

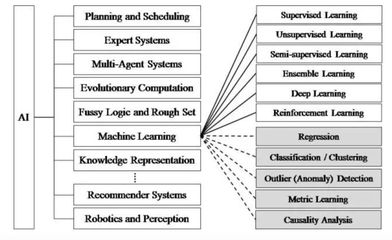

在嵌入式AI中,由于算力有限,我們通常不會運行龐大的深度學習模型,而是采用更傳統或輕量化的方法。

- 特征提取:從處理后的圖像中提取有意義的數值特征。例如,在識別數字時,可以提取圖像的Hu矩、輪廓特征等。在上面的色塊例子中,

blob.cx(),blob.cy(),blob.area()等本身就是特征。 - 簡單分類器:使用提取的特征進行決策。

- 閾值判斷:最簡單的“AI”。例如,如果

blob.area() > 500,則認為是大物體。

- K近鄰(KNN):可以在PC上訓練一個簡單的KNN模型,然后將模型參數(特征空間中的點及其標簽)硬編碼到MicroPython代碼中,實現簡單的分類。

- 決策樹:同樣可以將訓練好的樹結構(if-else規則)移植到嵌入式端。

示例:一個簡單的顏色分類“AI”

`python

# 假設我們已經捕獲圖像img

blobs = img.find_blobs([(0, 100, 0, 100, 0, 100)], merge=True) # 大致找出色塊

for blob in blobs:

# 提取特征:平均顏色

stats = img.getstatistics(roi=blob.rect())

avgcolor = (stats.lmean(), stats.amean(), stats.b_mean()) # 在LAB色彩空間可能更好

# 基于規則的簡單分類器

if avgcolor[0] > 80: # L通道亮度高

label = "淺色物體"

elif avgcolor[1] > 0: # A通道偏紅

label = "偏紅物體"

else:

label = "其他"

img.draw_string(blob.x(), blob.y()-10, label, color=(255,0,0))

print("檢測到:", label, "坐標:", blob.cx(), blob.cy())`

五、進階方向與挑戰

- 使用預訓練輕量級模型:將TensorFlow Lite Micro (TFLM) 或ONNX Runtime移植到MicroPython平臺,運行針對微控制器優化的神經網絡模型(如MobileNetV1/V2的量化版本),實現人臉檢測、關鍵字識別等。這是一項復雜的工程,但已有一些社區項目在探索。

- 內存與速度優化:嵌入式開發的核心挑戰。需要精心設計算法,使用低分辨率圖像,減少循環和浮點運算,充分利用硬件加速(如ESP32的DSP指令)。

- 數據傳輸:可以將原始圖像或處理后的特征通過Wi-Fi(如ESP32)發送到云端服務器進行更復雜的AI分析,實現邊緣+云協同。

###

通過MicroPython進行機器視覺和人工智能基礎開發,是一個從理論到實踐的絕佳切入點。它讓我們能在極其有限的資源下,理解圖像數據如何被獲取、處理和解析,并實現簡單的智能決策。雖然無法與服務器級的AI能力媲美,但對于許多IoT應用(如智能門鈴、簡單分揀、環境監測)來說,這種在終端設備上實現的“小智能”至關重要。從捕獲第一個像素開始,逐步構建你的嵌入式視覺AI系統吧!